Cuando la araña de Google visita tu sitio web, lo primero que hace es pasar por dos archivos cruciales en el mundo SEO: el archivo robots.txt y el sitemap.xml

El bot de Google analiza en el robots.txt que permisos tiene y que carpetas y rutas puede visitar. Luego, irá en busca del sitemap.xml donde seguirá una a una las url alli especificadas para después pasar a escanearlas e indexarlas. Si no tiene esa guía; el buscador tendrá que ir al home del sitio web y comenzar a scanear cada enlace sin la garantía de que tome los contenidos nuevos y recién publicados.

Los sitemaps facilitan el trabajo de escaneado e indexado del sitio web por parte de los bots, no tenerlo es no usar óptimamente el presupuesto de rastreo (crawl Budget). En esencia el sitemap es un archivo escrito en código xml que le indica al agente del buscador donde se encuentran las páginas y los contenidos. Se ubica en la raíz del servidor que aloja al sitio web para facilitar su exposición ante los buscadores.

Existen varios tipos de sitemap y pueden ser publicados juntos y agrupados a través de un sitemap índice:

- Sitemap índice. – es un archivo que Incluye todos los sitemap existentes

- Sitemap general. -Es un archivo general del sitio

- Sitemap de videos. -Es un archivo específico de video

- Sitemap de imágenes. -Es un archivo específico de imágenes

- Sitemap de Noticias. -Es un archivo sitemap especial para noticias

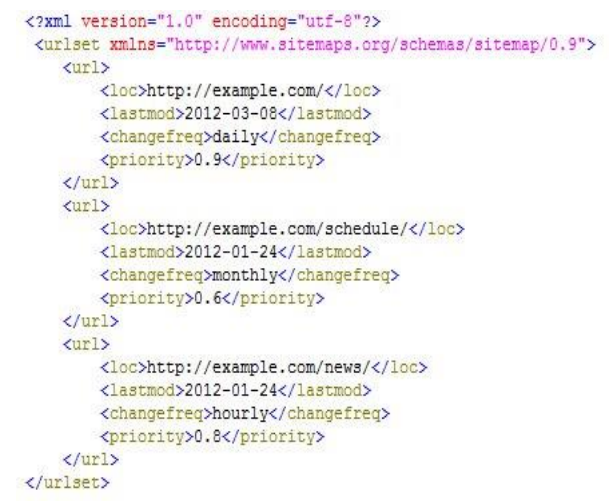

Los sitemap tienen una estructura característica formada por tres etiquetas fundamentales que vienen de pares una abre y otra que cierra. Las primeras son las etiquetas <urlset> </urlset> que comienzan y terminan el código del archivo xml.

Las segundas son las etiquetas <url></url> que sirven para separar una página de la otra y la etiqueta <loc> </loc> que especifican la locación de la url de la página..

Adicionalmente, podemos decirles a los buscadores cuál fue la última modificación de cada URL (en la etiqueta <loc>) con el operador <lastmod>. Cada cuánto tiempo cambia una URL con la etiqueta <changefrec> y una escala de prioridades de indexación con la etiqueta <priority>.

Todas juntas y combinadas deben lucir algo como esto:

Pero esta codificación no se hace manualmente, tardaríamos mucho; un blog pequeño puede tener 15 o 20 urls que indexar, pero un sitio web grande puede tener más de 100 mil. Por eso generalmente usamos para ese fin un software especializado como https://www.xml-sitemaps.com/ que generará este archivo de forma automática.

Aca hay que hacer algunas precisiones, cuando tenemos un sitio web de muchas páginas, generamos varios sitemap de 50 mil urls y los agrupamos a través de un sitemap índice. El índice de sitemap también tiene su propia sintaxis. Para conoce en profundidad recomiendo https://www.sitemaps.org/es/protocol.html, alli te puedes enterar de todos los detalles del protocolo.

El procedimiento debería ser:

- Generar el sitemap con un programa generador

- publicarlo en la raíz del site, ejemplo: www.misitio.com/sitemap.xml

- Notificarle cada uno de los archivos a Google Search Console y solicitar que los indexe.

- Hay que esperar el resultado de la indexación, si es satisfactoria, es decir si indexó la totalidad de los url añadidos en los archivos, todo estará finalizado satisfactoriamente.

- ¿Qué sucede si el número de páginas indexadas es menor al número de páginas que contiene el sitemap? Tendríamos que revisar cuáles son los errores corregirlos y volver a subir los archivos y repetir los pasos anteriores.

También puedes visitar mi caja de herramientas donde están agrupados varios enlaces a soluciones que te ayudarán con este tema.